Azure

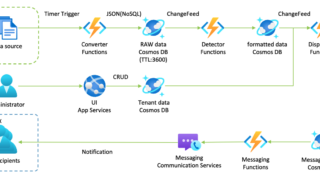

Azure Azure Functions (Python) + Cosmos DBまとめ

はじめに

Cosmos DB for NoSQLのオススメ言語はC# / Node.jsなのだけれど、AIや他のソリューションと組み合わせる時にPythonの膨大な資産はやはり魅力的なこともあり、Azure FunctionsをPy...

Azure

Azure  Mac

Mac  自転車

自転車  IT

IT  Red Hat

Red Hat  養蜂

養蜂  養蜂

養蜂  養蜂

養蜂  養蜂

養蜂  養蜂

養蜂  LIFE

LIFE  養蜂

養蜂  写真

写真  養蜂

養蜂  写真

写真