LIFE

LIFE Nespressoのリサイクルのやつ

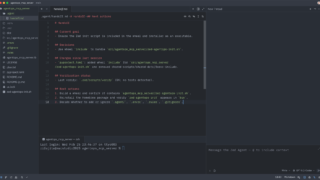

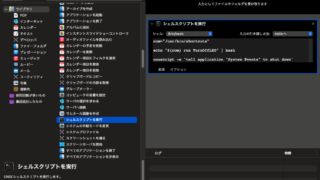

フォームの出来が悪くて入力が面倒なので、作った。というか、仕事の片手間にGPT-5.4に作ってもらった、が正しいw

Mac

Mac  AI

AI  LIFE

LIFE  Mac

Mac  Mac

Mac  Python

Python  LIFE

LIFE  LIFE

LIFE  LIFE

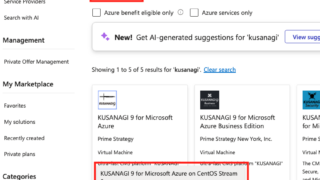

LIFE  Azure

Azure  Mac

Mac  Azure

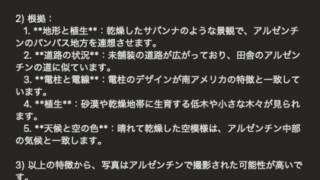

Azure  GeoGuessr

GeoGuessr  LIFE

LIFE  Azure

Azure  LIFE

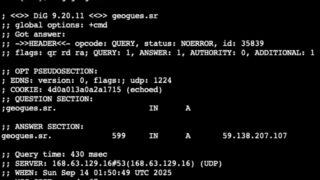

LIFE  GeoGuessr

GeoGuessr  GeoGuessr

GeoGuessr  LIFE

LIFE  未分類

未分類  GeoGuessr

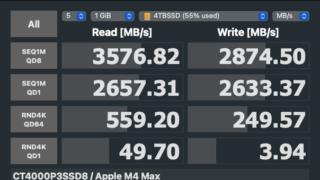

GeoGuessr  Mac

Mac  Mac

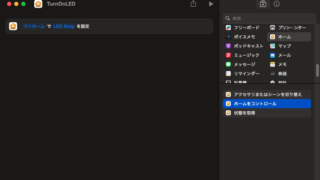

Mac  Mac

Mac  LIFE

LIFE  LIFE

LIFE  LIFE

LIFE  LIFE

LIFE  LIFE

LIFE  LIFE

LIFE  LIFE

LIFE